LACが社内で実践する生成AIの取り組みと、新たなセキュリティ対策とは?【JapanSecuritySummit 2023 ラック セッションレポート】

ChatGPTは、インターネット上の大量データから質問に対する答えを探して回答することから、いま大きな話題となっている。しかし、入力データはAIの再学習等のために利用され、入力した内容に機密情報などが含まれる場合に情報流出のリスクが懸念される。そのような懸念を取り除き、安全にChatGPTを利用するにはどうすればよいのであろうか? 株式会社ラック AIプロダク開発グループのザナシル・アマル氏が、自社の専用ChatGPTサービス・LACGAIと、それに関わるセキュリティの脅威と対策について解説した。

AI技術に関するラック社内の方針と、生成AIに関する取り組みとは?

ラックでは、これまでもAI技術を利用したソリューションを開発してきましたが、その注力領域には2本の柱があります。1つ目の柱は「セキュリティ×AI」であり、セキュリティ領域で高度なAIを活用することで、不正や異常を検知するものです。2つ目の柱は業務効率化を目的として開発を続けています。AIをビジネスに応用すべく、産学連携で研究も行い、明治大学 高木友博教授と共にAIの先端研究を進めているところです。

以前は、AIによる営業の高度化や自然言語の活用は難しかったのですが、ChatGPTの登場により状況が大きく変わり、容易に実現できる土台ができあがりました。すでに当社が金融分野で開発したAI不正取引検知ソリューションの「ZeroFraud」も、現在生成AIを活用できるように改良を加えているところです。

またラックでは、社内において生成AI(GAI:Generative AI)の活用を推進する活動を行っています。たとえば、社内や顧客の業務にもGAIを活用する目的で、ラックGAI CoE(Generative AI Center of Excellence)というバーチャルチームを編成しました。全社員が利用しているコミュニケーションツールのTeamsに生成AIを組込んだ「ChottoChat」や、MicrosoftのAzure Open AI Serviceを活用した独自AIサービスの「LACGAI」も社内で開発し、すでに運用しています。また技術だけでなく、いつでも社員がGAIを身近で使えるように、希望者に対して「ChatGPT Plus」も利用できるように配慮しています。

ラック社内で自社開発! 生成AIを利用した対話型AIアシスタント 「LACGAI」

ここからは、いまラックが注力しているLACGAIについて紹介します。前出のように当社では、対話型AIアシスタント・LACGAIを構築して社内で検証中です。これは一般的な質問だけでなく、自社データも参照して回答を生成する社内専用の対話型AIアシスタントです。システム構築にはAzure Open AI Serviceを利用していますが、これはエンタープライズのレベルでセキュリティ機能が担保されているためです。

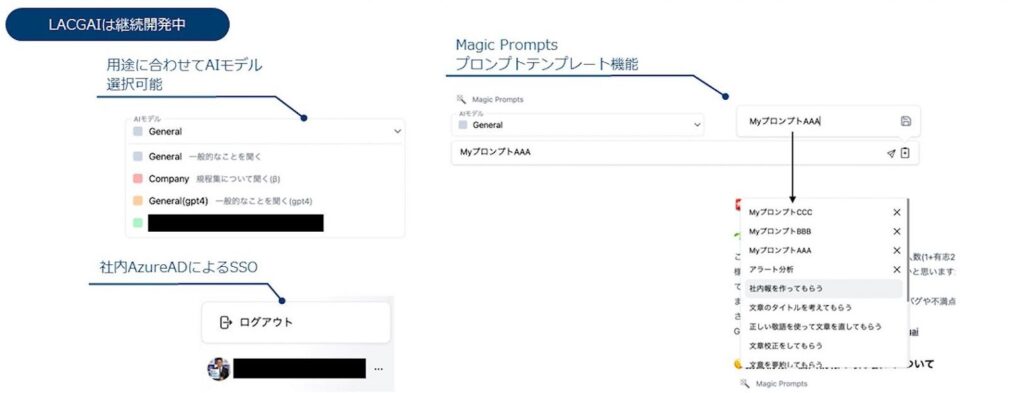

すでにLACGAIは、ラックの生成AIソリューションのコアとして位置付けられており、全社員がLACGAIを使える状況になっています。社員の業務に対して応用できるように継続的に改良・改善しているところです。さらにラック社内でソースコードをオープンにして、誰でも開発に積極的に参加できるようにしています。たとえば、継続開発中の機能としては、Microsoft Entra ID(Azure Active Directory)によるSSOでアクセスでき、メニューの「General」からChatGPT3.5と4.0を、「Company」から当社の規定書に検索がかけられます。ChatGPTを活用する際に重要なプロンプトについても、業務の用途ごとにプロンプトのテンプレートを用意しています。

RAGを採用! 企業版大規模言語モデル(LLM)のアプリの仕組み

一般的な質問だけでなく、LACGAIのように自社の業務なども答えてくれるようにするには、LLMをカスタマイズする必要があります。たとえば、OpenAIが提供するChatGPTのような基盤モデルに対して、独自のデータセットを用意してFine-Tuningする方法があります。しかし、この方法はAIモデルの学習コストや専門知識や手間がかかります。

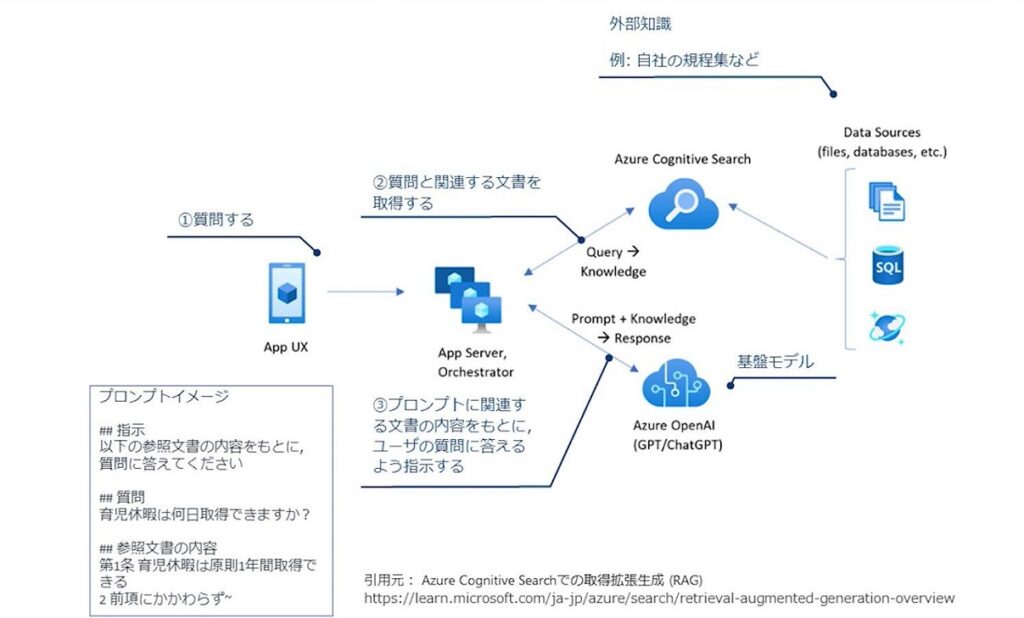

それに対して、当社ではRAG(Retrieval Augmented Generation)という方法を採用しています。これは基盤モデルはそのままにして、DBやファイルなどの外部知識を参照して回答するフレームワークになります。これならば別途の学習コストはかからずに、外部からの知識を社内の人間が確認できるというメリットもあります。

RAGでは、まず質問を受け付けるアプリのインタフェースを用意します。ここで①ユーザーが自社に関わる問いなど、さまざな質問を投げると、②質問に関連する文書を取得できます。検索エンジンとしてAzure Cognitive Searchを使っており、自社の規程集などのファイルやデータベースなどから、質問に応じて最も関連度が高い文書を取ってきます。そして③で質問した内容と関連文書によって、その背後でアプリがプロンプトを自動生成し、基盤モデル(Azure OpenAIで使えるGPT/ChatGPT)に対して問い合わせを行うという流れになります。

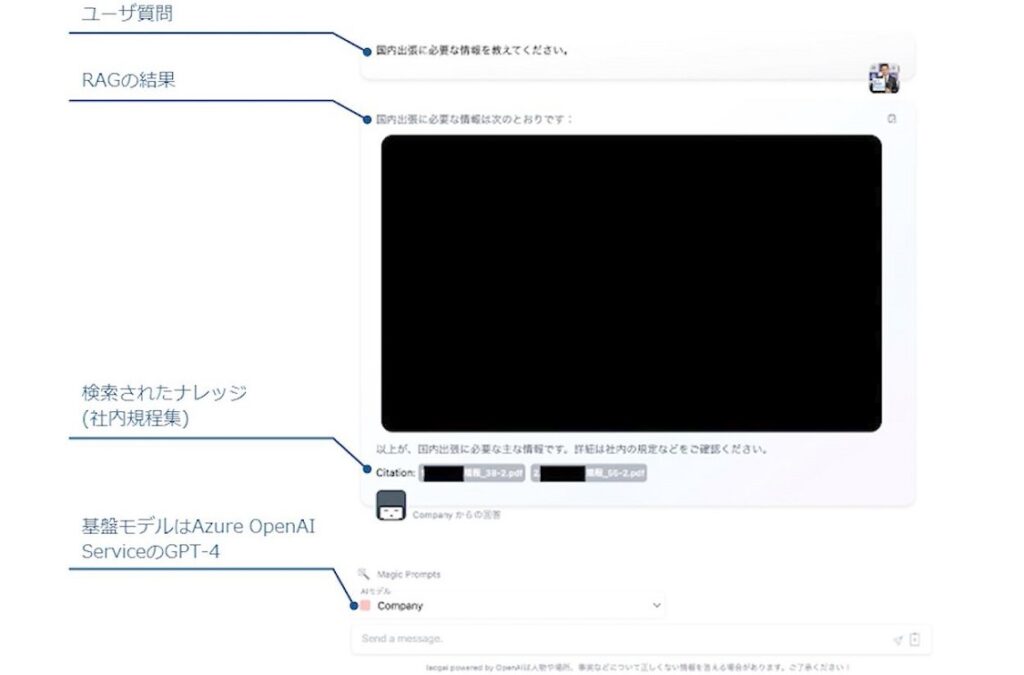

具体的なLACGAIのRAGのイメージは以下の通りです。たとえば、ユーザーが「国内出張について知りたい」と質問します。RGAからの結果が返ってきて、国内出張の情報が画面に出てきます。さらに検索されたナレッジとして社内規定集を引用しているというように「参照元」も示してくれるため、そこで質問者が裏どりの確認ができるようになります。

生成AI(LLM)アプリのセキュリティと対策はどうすべきか?

このように当社では、生成AI(LLM)アプリを社内で開発してきましたが、ここからはセキュリティに関しての考え方についても紹介します。当然ですが、従来のクラウド・ネイティブアプリのセキュリティが基本的に重要になります。これらに加えて、生成AI特有のものとして、さらにデータ入出力のハンドリングや、データ自体、AIモデルに対するセキュリティも求められます。

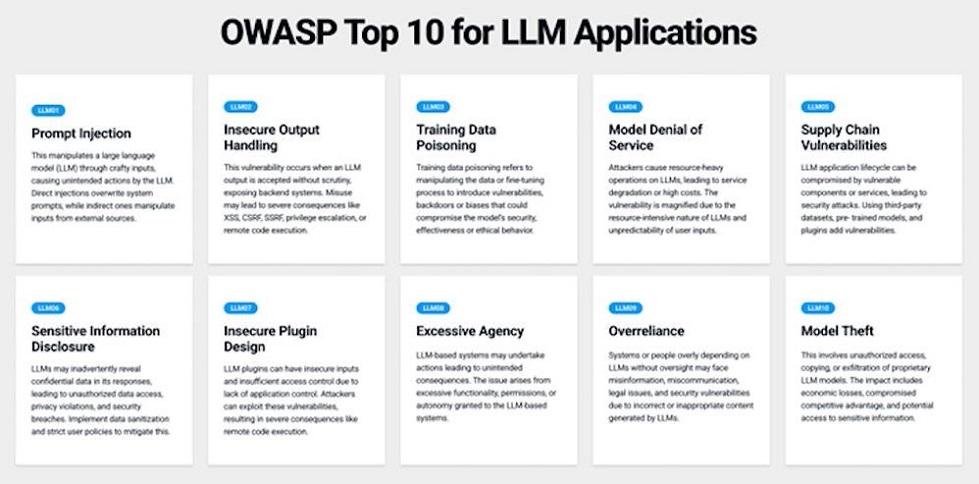

Webアプリケーションを取り巻く課題の解決を目指すオープンなコミュニティ・OWASP(Open Worldwide Application Security Project)では、LLMアプリに対するセキュリティTop10(https://llmtop10.com/)を公開しています。これをみると、たとえば悪意あるデータで生成AIが意図しない動きさせる「Prompt Injection」や「Training Data Poisoning」(トレーニングデータの改ざん)、安全でない出力処理、機密情報開示、サプライチェーンの脆弱性などに注意する必要があることが分かります。

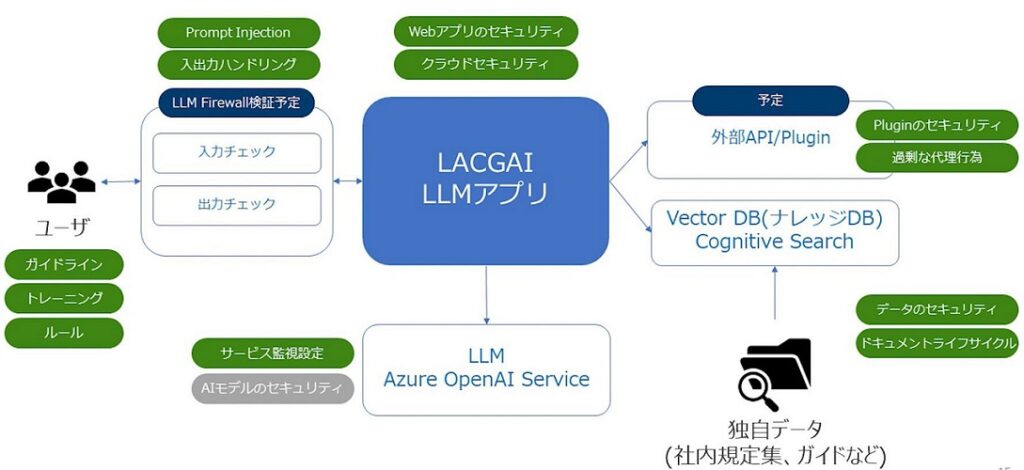

これらを踏まえて、LACGAIのセキュリティ対策については以下のようになります。

まず、LLMアプリ自体(LACGAI)には、従来のWebアプリやクラウドに対するセキュリティ対策を適用しました。また今回はAPIを通じてMicrosoft Azure OpenAI Service(LLM)上でAIモデルを開発したので、AIレベルのセキュリティは同社のベストプラクティスに合わせています。さらにサービス監視の設定も行いました。今後AIモデルを独自開発する場合には、AIモデル自体のセキュリティ(AIモデルの学習データの信頼性や盗難防止)にも考慮が求められます。

次に入力側については、ユーザー側で守るべきガイドラインやルールなどを準備し、質問入力時には前出のPrompt Injectionへの注意や、出力時にはコンプライアンス的に望ましくないデータのチェックなど、入出力のハンドリングを行いました。さらに入出力のチェックを強化するために「LLM Firewall」を検証する予定です。これは入出力に悪意あるキーワードや個人情報などが含まれていたときにアラートを出す仕組みです。

参照する社内の独自データ類には規程集やガイドなどがありますが、そのデータをどこまで参照させるべきかといったセキュリティの担保や、ドキュメント全体のライフサイクルにも留意しました。現在、外部APIは利用していませんが、何かほかの外部の検索エンジンに問い合わせたり、メール送信やChatにメッセージを投げるなど過剰な代理行為をさせていないか、API自体にセキュリティホールがないかといった点も考慮する必要があります。

ラックが考えるセキュリティにおけるAIの活用とは?

現在、ラックではLACGAIを使いながら、社内業務に適用するため、以下のような多くのAI活用のアイデアを練っています。

当社はセキュリティを中心にした基盤構築や脆弱性検知・監視、インシデント対応など、さまざまなソリューションやサービスを提供しています。そこで、これらの業務に生成AIを利用していく方針でます。たとえば、セキュリティ基盤構築において、開発コーディングの効率化や、開発調査、あるいは脆弱性診断では手動診断を自動化したり、診断レポートのベースを生成AIに任せたりというように、多方面への業務応用を考えています。そのコアとなるのが前出のLACGAIというわけです。これを各業務に特化させていく予定です。

いずれにしてもAIは非常に強力な武器になるものです。ただし、あくまで道具であって、その目的がAIの導入になってはいけません。いかにAIをビジネスに適用していくのか? という点が重要です。今後もラックは生成AIに関する業務適用の方法やセキュリティに関する研究・開発を続けていきます。また当社はAIソリューションの協業パートナーも募集しています。ぜひお声がけください。